什么是robots.txt?robots.txt有什么作用呢?标准的robots.txt应该怎么写?对于一个网站优化新手来说这也是很头疼的问题的,下面由牛牛来逐一为大家分析。

robots.txt其实就是一个文本文件,使用任何一个常见的文本编辑器都可以编辑它,例如最简单的一种编辑方法直接点击鼠标右键新建一个文本文档就可以编辑,但是一定要注意后缀.txt 。 robots.txt是搜索引擎中访问网站的时候要查看的第一个文件,robots.txt文档的内容就是告诉蜘蛛程序被搜索的网站什么文件是可以被查看的什么是不可以查看的。

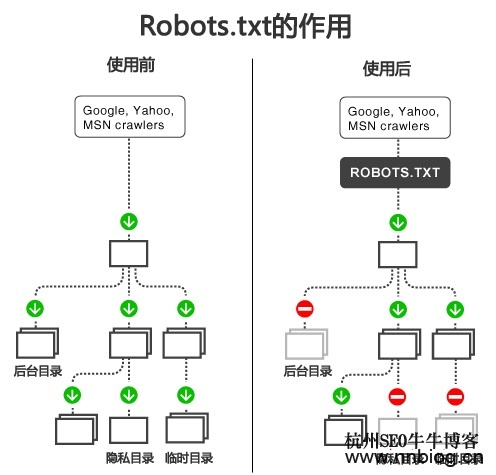

如果将网站视作一个大型酒店,robots.txt就是客人在房间门口悬挂的“请勿打扰”或“欢迎打扫”的提示牌。门口悬挂的牌子就是告诉工作人员哪些房间可以进入打扫,哪些房间因为存放贵重物品,或可能涉及住户的隐私而不对外开放。网站中的robots.txt也是同样一个道理,告诉搜索引擎网站中的哪些文件是公开的可以被抓取哪些是不方便的不可以被抓取。但是如果该文件不存在,那么搜索机器人就沿着链接抓取。

在解释robots.txt标准的写法之前牛牛先为大家介绍一下Robots的三个语法和两个通配符

三个语法如下:

1、User-agent:(定义搜索引擎)

例如:

User-agent: *(定义所有搜索引擎)

User-agent: Googlebot (定义谷歌,只允许谷歌蜘蛛爬取)

User-agent: Baiduspider (定义百度,只允许百度蜘蛛爬取)

不同的搜索引擎的搜索机器人有不同的名称,谷歌:Googlebot、百度:Baiduspider、雅虎:Yahoo 等

2、Disallow:(用来定义禁止蜘蛛爬取的页面或目录)

例如:

Disallow: /(禁止蜘蛛爬取网站的所有目录 "/" 表示根目录下)

Disallow: /admin (禁止蜘蛛爬取admin目录)

Disallow: /abc.html (禁止蜘蛛爬去abc.html页面)

Disallow: /help.html (禁止蜘蛛爬去help.html页面)

3、Allow:(用来定义允许蜘蛛爬取的页面或子目录)

例如:

Allow: /admin/test/(允许蜘蛛爬取admin下的test目录)

Allow: /admin/abc.html(允许蜘蛛爬去admin目录中的abc.html页面)

两个通配符如下:

1、匹配符 “$”

$ 通配符:匹配URL结尾的字符

2、通配符 “*”

* 通配符:匹配0个或多个任意字符

接下来就是标准的robots.txt写法大全了

1、如果允许所有搜索引擎访问网站的所有部分

User-agent: *

Disallow:

或者

User-agent: *

Allow: /

2、如果我们禁止所有搜索引擎访问网站的所有部分

User-agent: *

Disallow: /

3、如果我们需要禁止某一个搜索引擎的抓取的话,比如百度,禁止百度索引我们的网站

User-agent: Baiduspider

Disallow: /

如果禁止谷歌的话则是

User-agent: Googlebot

Disallow: /

就是User-agent:头文件的蜘蛛名字变一下

4、如果我们禁止除Google外的一切搜索引擎索引我们的网站

User-agent: Googlebot

Disallow:

User-agent: *

Disallow: /

5、如果我们需要禁止蜘蛛访问某个目录,比如禁止admin、css、images等目录被索引

User-agent: *

Disallow: /css/

Disallow: /admin/

Disallow: /images/

6、如果允许蜘蛛访问我们网站的某个目录中的某些特定网址

User-agent: *

Allow: /css/my

Allow: /admin/html

Allow: /images/index

Disallow: /css/

Disallow: /admin/

Disallow: /images/

7、如果禁止抓取网站中所有的动态页面

User-agent: *

Disallow: /*?*

屏蔽所有带“?”的文件,这样就屏蔽所有的动态路径。

8、如果禁止百度蜘蛛抓取网站所有的图片

User-agent: Baiduspider

Disallow: /*.jpg$

Disallow: /*.jpeg$

Disallow: /*.gif$

Disallow: /*.png$

Disallow: /*.bmp$

9、如果除了百度之外和Google之外,禁止其他搜索引擎抓取你网站的图片

(注意,在这里为了让大家看的更明白,因此使用一个比较笨的办法——对于单个搜索引擎单独来举例。)

User-agent: Baiduspider

Allow: .jpeg$

Allow: .gif$

Allow: .png$

Allow: .bmp$

User-agent: Googlebot

Allow: .jpeg$

Allow: .gif$

Allow: .png$

Allow: .bmp$

User-agent: *

Disallow: .jpg$

Disallow: .jpeg$

Disallow: .gif$

Disallow: .png$

Disallow: .bmp$

10、如果仅仅允许百度抓取网站上的“JPG”格式文件

( 其他搜索引擎的办法也和这个一样,只是修改一下搜索引擎的蜘蛛名称即可)

User-agent: Baiduspider

Allow: .jpg$

Disallow: .jpeg$

Disallow: .gif$

Disallow: .png$

Disallow: .bmp$

11、如果仅仅禁止百度抓取网站上的“JPG”格式文件

User-agent: Baiduspider

Disallow: .jpg$

在编辑robots.txt文本文档还有几个需要注意的地方如下:

1、文件名称不能写错,而且必须小写,后缀必须是.txt.

2、文件必须放在网站的根目录,比如:http://www.nnbiog.cn/robots.txt,要可以访问。

3、文件内容语法要正确,一般情况下,常用的就是User-agent和Disallow:

所以robots.txt在SEO网站优化中也是至关重要的,希望大家在编辑的时候一定要认真以免带来不必要的损失

阅读完牛牛博客的本篇文章后希望您在操作robots.txt的时候能有所帮助,感谢您对牛牛博客的支持,请时刻关注牛牛博客,这里更新的文章内容都是非常有价值的。

关注我们:请关注一下我们的微信公众号:扫描二维码

,公众号:xieniuniu8888

,公众号:xieniuniu8888版权声明:本文为原创文章,版权归 牛牛博客 所有,欢迎分享本文,转载请保留出处!